डीपफ़ेक फिर से सुर्खियों में है। फिर से ग़लत वजहों से। मशहूर अभिनेत्री रश्मिका मंदाना का एक डीपफ़ेक वीडियो वायरल हुआ है। डीपफ़ेक का आसान मतलब है फ़ेक लेकिन इतना सॉफिस्टिकेटेड फेक कि इसको आसानी से नकली के रूप में पहचानना बेहद मुश्किल है। रश्मिका मंदाना के डीपफ़ेक वीडियो वायरल को लेकर अब आईटी मंत्री राजीव चंद्रशेखर ने सोशल मीडिया प्लेटफार्मों को बड़ी चेतावनी दी है।

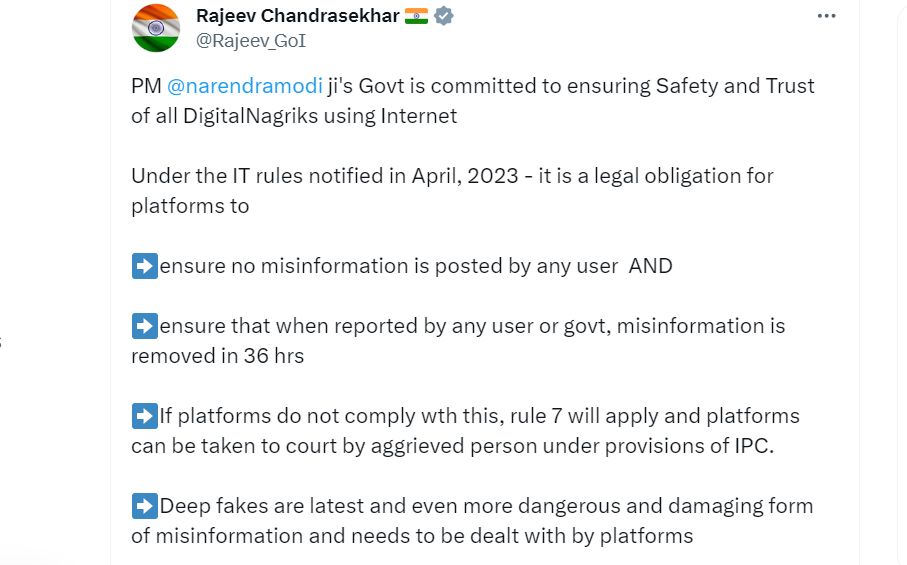

केंद्रीय मंत्री राजीव चंद्रशेखर ने अभिनेत्री रश्मिका मंदाना के वायरल डीपफेक वीडियो को लेकर सोशल मीडिया प्लेटफार्मों को गलत सूचना से लड़ने के लिए उनके कानूनी दायित्वों की याद दिलाई। वीडियो में मूल रूप से ब्रिटिश-भारतीय इन्फ्लुएंसर ज़ारा पटेल को दिखाया गया था, लेकिन डीपफेक में उनके चेहरे की जगह अभिनेत्री रश्मिका का चेहरा लगा दिया गया। सोशल मीडिया एक्स पर केंद्रीय आईटी राज्य मंत्री ने कहा कि प्रधानमंत्री नरेंद्र मोदी के तहत केंद्र सरकार इंटरनेट का उपयोग करने वाले सभी नागरिकों की सुरक्षा और विश्वास सुनिश्चित करने के लिए प्रतिबद्ध है।

अप्रैल 2023 में अधिसूचित आईटी नियमों का हवाला देते हुए केंद्रीय मंत्री ने उन दिशानिर्देशों को बताया जिनका सोशल मीडिया प्लेटफार्मों को कानूनी दायित्व के रूप में पालन करना होगा। चन्द्रशेखर ने कहा कि सभी प्लेटफार्मों को सुनिश्चित करना चाहिए कि किसी भी यूज़र द्वारा कोई गलत सूचना पोस्ट न की जाए और जब सरकार को किसी भी यूज़र द्वारा रिपोर्ट की जाती है तो गलत सूचना को 36 घंटों में हटा दिया जाए।

उन्होंने आगे लिखा कि यदि सोशल मीडिया प्लेटफॉर्म नियमों का पालन करने में विफल रहते हैं तो नियम 7 लागू किया जाएगा और प्लेटफॉर्म को आईपीसी के प्रावधानों के तहत पीड़ित व्यक्ति द्वारा अदालत में घसीटा जा सकता है।

I feel really hurt to share this and have to talk about the deepfake video of me being spread online.

— Rashmika Mandanna (@iamRashmika) November 6, 2023

Something like this is honestly, extremely scary not only for me, but also for each one of us who today is vulnerable to so much harm because of how technology is being misused.…

मूल वीडियो 9 अक्टूबर को इंस्टाग्राम पर साझा किया गया था, जिसमें ब्रिटिश-भारतीय लड़की ज़ारा पटेल दिखी थीं। डीपफेक वीडियो में महिला को काले रंग की पोशाक पहने हुए और लिफ्ट में प्रवेश करते हुए दिखाया गया है। गौर से देखने पर पता चलता है कि लिफ्ट में घुसते ही महिला का चेहरा बदलकर रश्मिका जैसा हो जाता है। हालाँकि, यह रहस्य बना हुआ है कि नकली वीडियो किसने बनाया।

क्या है डीपफ़ेक?

डीपफ़ेक एक तरह से फ़ेक यानी नकली चीज के लिए इस्तेमाल होता है। लेकिन यह इतनी गहराई से यानी सॉफिस्टिकेटेड तरीक़े से नकली बनाया जाता है कि इसको पकड़ना बेहद कठिन होता है कि यह नकली बनाया गया है। इसका इस्तेमाल आम तौर पर तस्वीरों और वीडियो के लिए होता है।

ऑरिजिनल या मौजूदा तस्वीर और वीडियो में एक व्यक्ति की जगह किसी दूसरे व्यक्ति के चेहरे, हावभाव या आवाज़ को लगा दिया जाए और इतनी समानता हो कि उनमें अंतर करना कठिन हो तो यह डीपफ़ेक है। 'डीपफ़ेक' को आसान भाषा में ऐसे समझें। मोबाइल की कई कैमरा ऐप्स में यह सुविधा होती है कि किसी तस्वीर पर चेहरा बदला जा सकता है। इनमें तस्वीरें असली जैसी दिखती हैं, लेकिन होती नकली हैं। यही डीपफ़ेक है।

इसे और आसानी से समझना है तो दिल्ली विधानसभा चुनाव के दौरान तत्कालीन दिल्ली बीजेपी अध्यक्ष मनोज तिवारी का वह वीडियो याद कीजिए जिसमें उन्होंने एक ही वीडियो को कई भाषाओं में जारी किया था। दिल्ली विधानसभा चुनावों में प्रचार के लिए बीजेपी ने आर्टिफ़िशियल इंटेलिजेंस यानी एआई से बने 'डीपफ़ेक' वीडियो का सहारा लिया था। बीजेपी की तरफ़ से जारी वीडियो में मनोज तिवारी के वीडियो पर कई अलग-अलग भाषाएँ जोड़कर व्हाट्सऐप पर शेयर किया गया था और सभी वीडियो में वह ओरिजिनल ही लग रहे थे।

जब 1 लाख महिलाएँ आई थीं निशाने पर

साल 2020 में डीपफ़ेक ने तब तहलका मचा दिया था जब एक साफ़्टवेयर से 1 लाख से ज़्यादा महिलाएँ निशाना बनाई गई थीं। ये वे महिलाएँ थीं जिन्होंने वाट्सऐप जैसी ऐप टेलीग्राम के बॉट पर तस्वीरें अपलोड की थीं। बॉट एक तरह की आर्टिफ़िशियल इंटेलिजेंस या रोबोट की तरह साफ़्टवेयर एप्लिकेशन है जिसे एक निश्चित काम के लिए प्रोग्राम किया जाता है। बॉट पर डाली गई इन्हीं तस्वीरों को किसी ने चुपके से कम्प्यूटर द्वारा फ़ेक आपत्तिजनक तसवीरें बना दीं। तब शोधकर्ताओं ने यह दावा किया था।

सेंसिटी की एक रिपोर्ट में यह दावा किया गया था। सेंसिटी कंपनी आर्टिफ़िशियल इंटेलिजेंस को लेकर शोध करती रही है और ऑनलाइन की जाने वाली इस तरह की गड़बड़ियों पर रिपोर्ट प्रकाशित करती रही है। इसकी रिपोर्ट में कहा गया है कि इन 'डीपफ़ेक' तस्वीरों को मैसेजिंग ऐप टेलीग्राम पर बॉट के एक इकोसिस्टम द्वारा बनाया गया था, जो नकली आपत्तिजनक तस्वीरें बना सकता है। सेंसिटी द्वारा जारी रिपोर्ट के अनुसार एक खुफिया फ़र्म डीपफ़ेक करने में माहिर है।

हालाँकि डीपफ़ेक पर ज़्यादातर कवरेज राजनीति और चुनावों पर केंद्रित है लेकिन कई विशेषज्ञ चिंता जताते हैं कि इस तकनीक के वास्तविक शिकार वे लोग हो सकते हैं जो सामाजिक रूप से कमज़ोर हैं।

अपनी राय बतायें